Voici un petit tutorial sur MON utilisation d'IRIS, qui n'est pas forcément la meilleure, mais, pour l'instant, celle qui fonctionne le mieux chez moi pour l'acquisition et le traitement d'images

solaires (mais applicable aussi parfois sur d'autres films récalcitrants)

Pour un max d'infos, un seul lien : http://www.astrosurf.com/buil/iris/iris.htm

Pour l'acquisition, j'ai une webcam Phjilips SPC900 non modifiée. Je la paramètre en NB à 10im/s en 640*480. Cela me donne un bon compromis entre cadence de capture et qualité d'image, du point

de vue du bruit, de la turbulence, de la compression de images...

Je capture toujours sur le disque C: de mon portable, d'une part parce que la partition D: semble endommagée partiellement, et d'autre part parce que la capture sur un support externe semble

moins fluide. Cela n'engendre pas de complications particulières car, une fois la session de capture terminée, il suffit simplement de tout transférer sur un autre support.

Une fois cette session terminée, je commence par archiver tous les films séparément en archives RAR pour un stockage et une gestion plus aisée par la suite. Ca me permet de réduire l'emcombrement

final d'un facteur 5 environ, et ce avant tout tri des films. Une fois gardé le best of des films les plus à même d'être gardés, une session peut la plupart du temps tenir sur un CD...

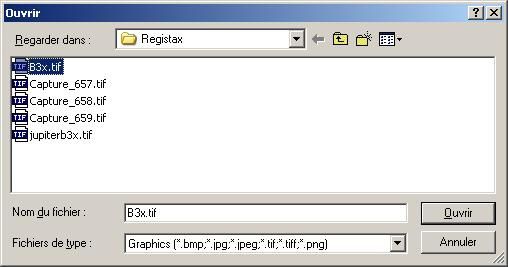

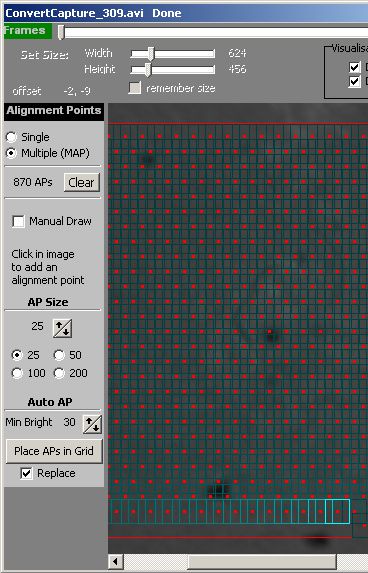

Ensuite, on peut attaquer les prétraitements. Dans IRIS, une fois la conversion du film effectué (Fichier->Conversion AVI, sélection de l'AVI, canal N&B nommé i, puis clic sur

"convertir"), il s'agit d'abord d'aligner toutes les images. Certains préfèrent d'abord faire un tri, mais je considère que le tri sera plus efficace sur un détail souhaité que sur l'ensemble

d'une image.

On charge la première image :

>load i1

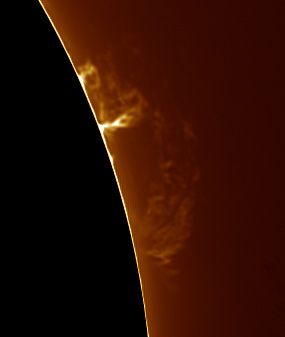

On sélectionne la zone qui va servir de référence pour l'alignement (de préférence une zone bien contrastée, et présente totalement sur toutes les images sans exception). Personnellement, je

choisis une zone pas trop grande, entourant un détail particulier que je considère comme principal dans le rendu final. En Halpha, je vais par exemple sélectionner une protubérance. Puis on va

donner les paramètres à appliquer pour calculer l'alignement :

>pregister i p 256 599

Pregister est la commande de base pour l'alignement des images planétaires. Cette commande demande le nom des images à aligner (i), le nom des images une fois l'alignement effectué (p), la taille

de la fenêtre à étudier pour estimer les dérives d'une image à l'autre (256), et pour finir le nombre d'images à aligner (599). Come je capture à 10im/s pendant 60s, je dois normalement obtenir à

chaque fois 600 images. Or, il peut arriver qu'une image passe à la trappe car le système, au moment de la capture de cette image, était occupé. Pour ce qui est de la taille de la fenêtre, on

peut proposer 64, 128, 256 ou 512. Plus la valeur est élevée, plus le traitement prendra de temps. a l'inverse, plus la valeur est faible, moins le traitement sera précis. Cela ne veut pas dire

qu'il faut tout le temps prendre 512. Simplement, on augmente la valeur sur des films plus exigents, où ça "bouge" plus...

Quand le traitement est terminé, on va pouvoir trier les images de la meilleure à la plus mauvaise. En opérant de cette façon, on va réellement trier en fonction d'un détail souhaité. Il peut

arriver que, lors de l'alignement, certaines images ne soient pas alignées. Cette méthode de tri va donc pouvoir écarter ces images décalées car ne correspondant pas au détail de référence. On

charge donc la première image alignée précédemment :

>load p1

Sur cette image, on encadre à la souris le détail qui nous intéresse le plus, puis on lance le traitement :

>bestof p 599

Rien à dire de particulier sur cette commande. Une fois le tri effectué, IRIS génère une liste classée des images. Il faut donc appliquer ce tri :

>select p s

Les images triées sont les images nommées s... Ensuite, j'additionne les images que je considère comme bonnes :

>add_norm s 150

Je considère que les 150 meilleures images du tri peuvent dans la grande majorité des cas être gardées. Je ne travaille pas à longue focale et à des diamètres plutôt faibles, donc la question de

la résolution ne se pose pas trop. Pour ce qui est de la fonction "add_norm", elle normalise le résultat de l'addition pour que le pixel ayant la valeur la plus élevée plafonne à 32700. Chaque

valeur de pixel (son intensité) est codée sur 16 bits, ce qui donne 32768 valeurs possible, 0 étant le noir total. Dans le cas de notre fonction ça nous garde un peu de marge mais pas forcément

suffisamment pour la suite des traitements. Du coup j'applique une autre commade :

>mult 0.75

Ceci permet de descendre toutes les valeurs de pixel à 75% de leur valeur d'origine. La valeur max descend donc à 24525. On retrouve donc de la marge pour la suite, car tout traitement par la

suite risque de réaugmenter les valeurs des pixels. Si on était déjà au maximum, ça donnerait alors des zones saturées, ce qu'on veut éviter par dessus tout...

Enfin, pour éviter d'avoir à refaire tout ça :

>save f

Cela sauve ce résultat au format FITT, format utilisé par IRIS pour garder l'image en 16 bits et travailler dessus.

Au passage, tout ce que nous venons de voir est un script présent dans la fenêtre script. Ce script est sauvegardable en le copiant-collant dans le notepad, par exemple (et réutilisable de la

même façon... Vous le tapez une fois pour toute, et ensuite c'est juste du copier-coller). De plus on peut revenir sur la plupart des étapes. Si le résultat final ne nous plait pas, on peut par

exemple reprendre l'étape de réalignement en changeant des paramètres. Cette façon de procéder demande un peu d'espace disque (environ trois à quatre fois la taille du film) mais cela garantit

des retours en arrière immédiats.

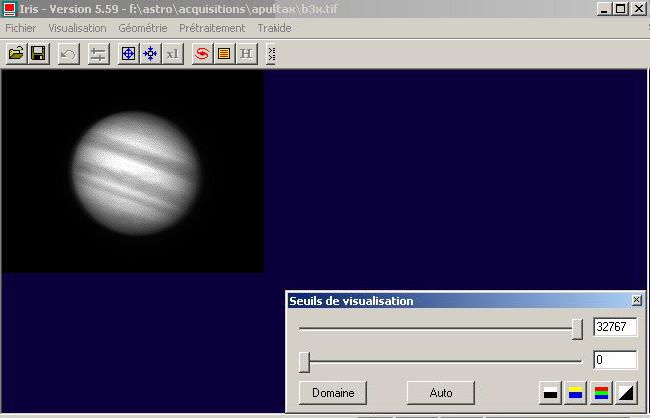

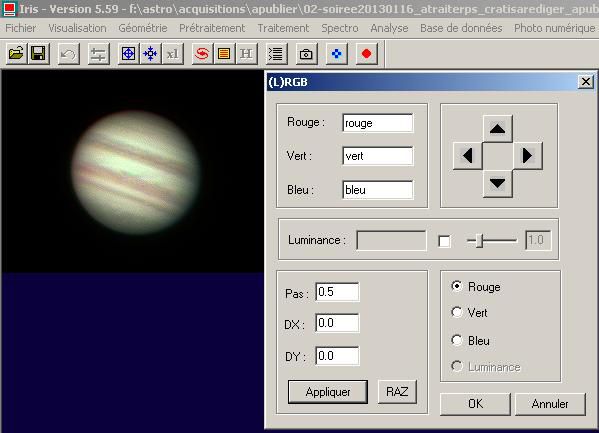

A ce stade, nous avons une image avec un aspect lissé, dans la mesure du possible, exempte de bruit. A partir de maintenant, on va pouvoir s'intéresser aux détails et essayer de les accentuer.

Les deux plus utilisés sont le masque flou et les ondelettes. Personnellement, je commence toujours par les ondelettes. Si cela ne donne rien de bon, le masque flou aura du mal à faire mieux...

Dans le menu ondelettes (traitements->ondelettes), je coche la case "verif. auto", ce qui permet de voir en temps réel ce qu'on fait. Ensuite je joue avec le premier curseur. C'est celui qui

agit sur les détails les plus fins, et dans la plupart des cas, si on part avec un film de bonne qualité en terme de mise au point, c'est le seul curseur qu'on devrait toucher. Attention par

contre car c'est aussi celui qui vous ramène le plus rapidement des artéfacts de traitement et du bruit... Tout est affaire de compromis. Maintenant, si la turbulence est très présente, vous ne

gagnerez pas grand chose. Pour avoir de bonnes images finales, il faut avoir de bonnes images au départ. IRIS ne fait pas de miracle.

Ensuite vous pouvez cumuler les traitements. D'abord des ondelettes, puis un masque flou, ou simplement deux masques flous... Seule votre imagination et le résultat final vont vous brider...

Quand l'objectif est atteint, on peut sauver le résultat. Pour moi, je sauve en BMP pour ensuite pouvoir ajuster ensuite le traitement avec d'autres logiciels :

>savebmp final

D'autres formats d'enregistrement sont disponibles. Voir la doc pour la liste.

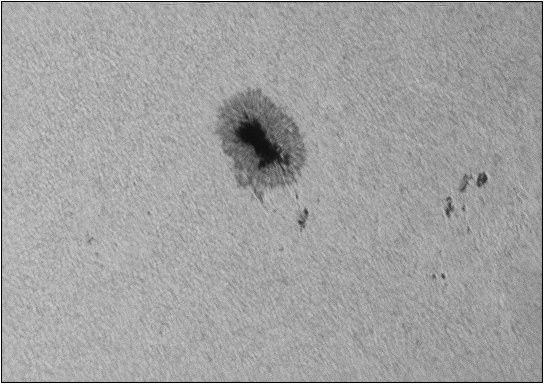

Ceci est le processus de base. Mais pour le Halpha, IRIS ne veut rien savoir. Il faut que je rajoute une étape intermédiaire pour lui faciliter le calcul d'alignement.

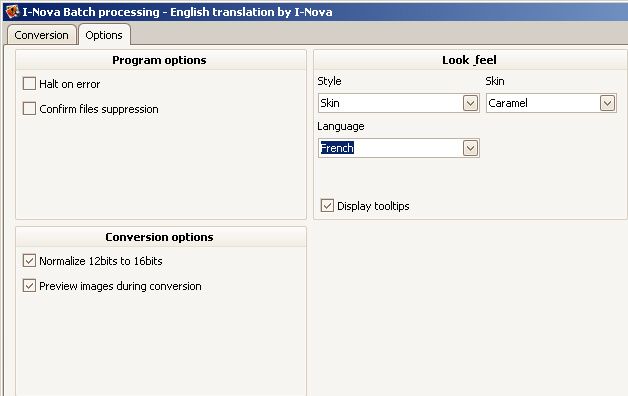

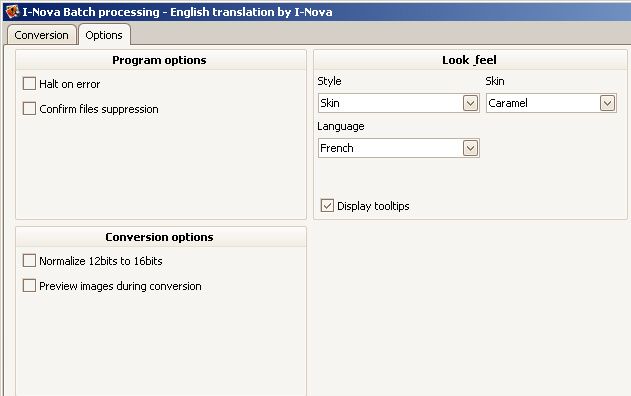

Une fois le fichier converti, j'applique un masque flou sévère sur la séquence d'images. Ceci a pour but d'accentuer au maximum le contraste et les détails de l'image : Menu traitement->

masque flou d'une séquence

Images d'entrée : i

Coef sigma : 5

facteur : 40

Images de sortie : m

Nombre : 599

Et on coche (si ce n'est déjà fait) planétaire

Ca donne une série d'images atroces et bourrées de défauts. C'est cette série qui va servir de référence pour effectuer l'alignement. Comme au début, on calcule l'alignement :

>pregister m p 256 599

Je ne reviens pas sur l'explication de cette commande. Ensuite, au lieu d'effectuer le bestof sur cette série, ce qui ne donnerait rien d'exploitable, on utilise le fichier résultat d'IRIS lors

du calcul d'alignement pour appliquer cet alignement sur les images i de départ :

>file_trans i p 599

On demande à IRIS d'aligner de la même façon les images d'origine que les images masque floutées...

Ensuite seulement, on reprends le script pour effectuer le bestof et l'addition. Si au départ, IRIS n'arrivait pas à calculer le bon alignement avec les images d'origine, avec celles de la série

du masque flou, l'alignement se fait sans soucis. Il se peut que ce soucis d'alignement ne soit du qu'aux images que je récupère du PST. Sur d'autres systèmes optiques, les images peuvent être

différentes, et donc cette méthode n'est pas utile. Encore une fois, je précise que cette méthode est faite pour des films récalcitrants, ici pour le HAlpha, mais peut être aussi utilisé

ailleurs.

A vous de tester maintenant, voire de peaufiner la méthode...